2. Attention U Net: Learning Where to Look for the Pancreas - yspaik/pytorch_study GitHub Wiki

- 논문 제목: Attention U-Net: Learning Where to Look for the Pancreas

- 논문 링크: https://arxiv.org/abs/1804.03999

- 소스코드: https://github.com/ozan-oktay/Attention-Gated-Networks

- Introduction

- attention 개념을 UNet에 적용

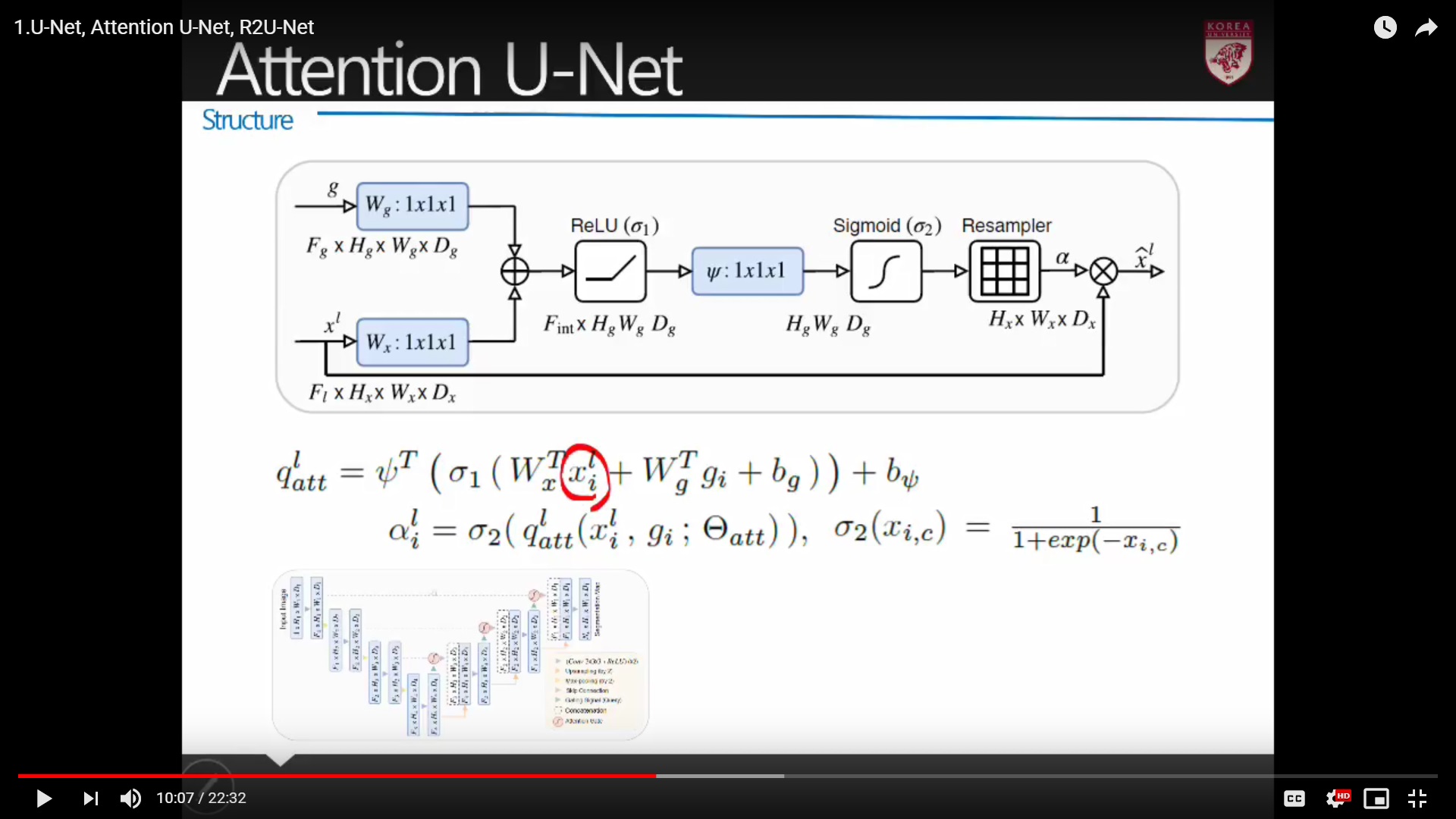

- Structure

- 같은 stage → feature의 크기가 같은 u-net 구조

- Attention Gateway를 지나는 부분이 일반 u-net과의 차별점

- Attention Gate

-

input은 두가지 : g, x

-

x는 encoder로부터 오는 feature

-

g는 decoder부분의 아래로부터 들어오는 gating signal

-

input feature X weight gating input signal X weight + bias 더한 후 → activation 통과

-

나온 feature map을 1x1x1 conv로 통과 차원 축소

-

다시 sigmoid 통과 → attention mask 역할

-

x (encoder로부터 전달된 feature)는 mask를 통과한 알파와 multiply

-

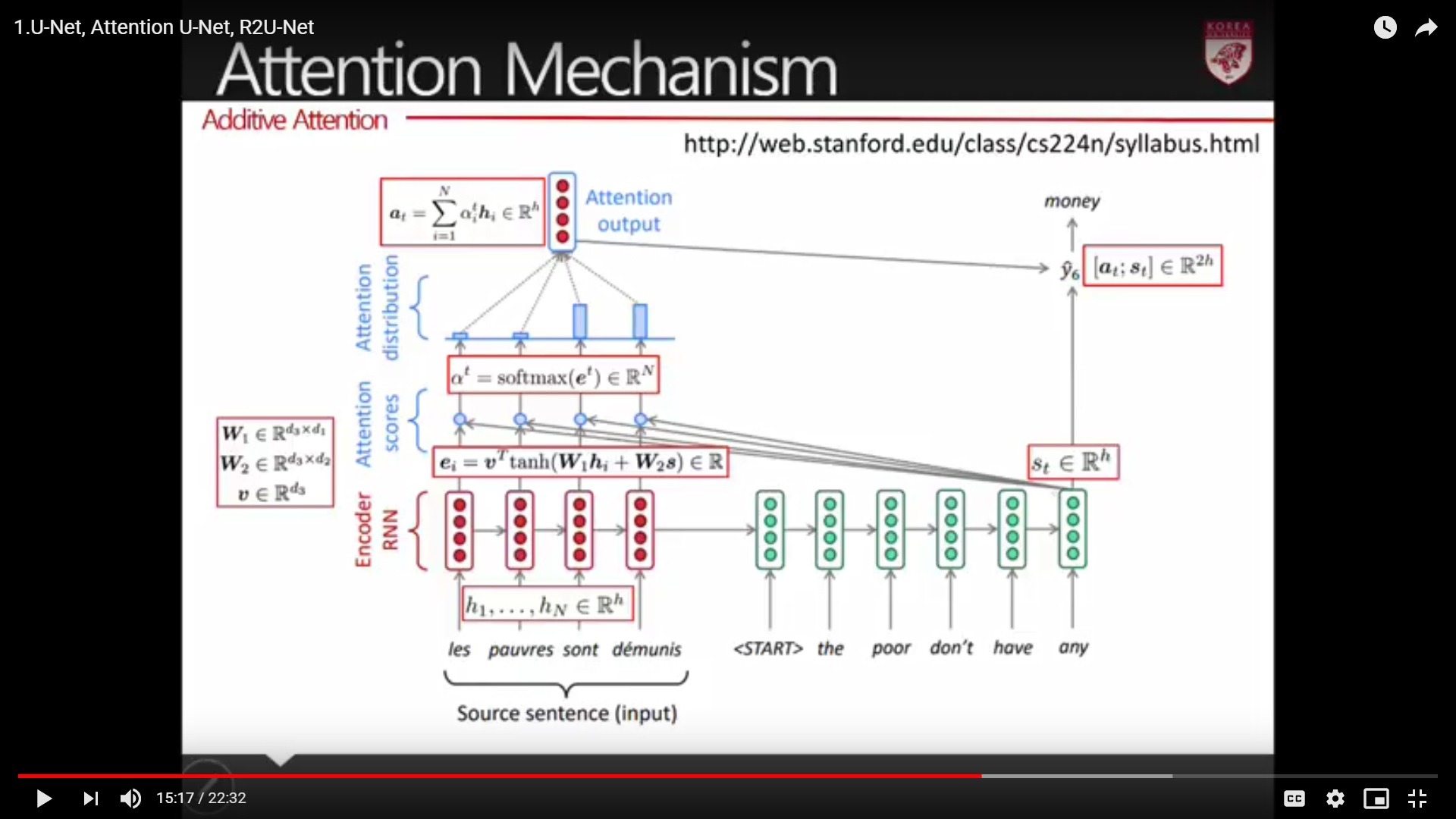

시그마 1 부분 영역 수식 : 기존 attention mechanism과 동일

-

참고: Additive Attention