深層学習後編(確認テストなど自身の考察結果) - s-manabe2/DeepLearningForEngeneerJUDACertificate GitHub Wiki

深層学習Day3

Section1:再帰型NNの概念

確認テスト

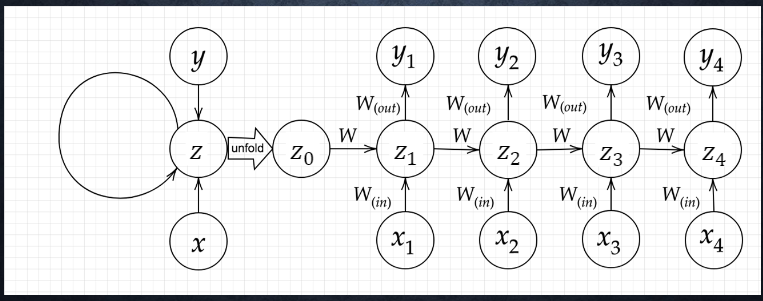

- Q.RNNのネットワークには大きくわけて3つの重みがある。1つは入力から現在の中間層を定義する際にかけられる重み、1つは中間層から出力を定義する際にかけられる重みである。残り1つの重みについて説明せよ。

- A. 中間層から中間層の重み

確認テスト

- Q. 下図のy1をx・s0・s1・Win・W・Woutを用いて数式で表せ。※バイアスは任意の文字で定義せよ。また、中間層の出力にシグモイド関数g(x)を作用させよ。

※図はZとなっているが、Sの誤記。

※図はZとなっているが、Sの誤記。 - A. y1=g(s1・Wout + c), s1= x1・Win + s0・W

Section2:LSTM

確認テスト

- Q.以下の文書をLSTMに入力し空欄に当てはまる単語を予測したいとする。文中の「とても」という言葉は空欄の予測において無くなっても影響を及ぼさないと考えられる。このような場合、どのゲートが作用するとかんがえられるか。 「映画おもしろかったね。ところで、とてもお腹がすいたから何が____」

- A. 忘却ゲート

Section3:GRU

確認テスト

- Q.LSTMとCECが抱える課題について、それぞれ簡潔に述べよ。

- A. LSTMの課題:パラメータ数が多く、計算負荷が高くなる問題がある。 CECの課題:入力データについて、時間依存に関係なく重みが一律である。つまり、ニューラルネットワークの学習特性がないという問題がある。

確認テスト

- Q.LSTMとGRUの違いを簡潔に述べよ。

- A. LSTMよりGRUの方が計算量が少ない。LSTMは入力ゲート、出力ゲート、忘却ゲート、CECがある。 GRUは、CECがない。リセットゲートと更新ゲートがある。LSTMがパラメータが多く、GRUの方がパラメータ少ない。

Section4:双方向RNN

確認テスト

- Q.下記の選択しから、seq2seqについて説明しているものを選べ。

- (1)時刻に関して順方向と逆方向のRNNを構成し、それら2つの中間層表現を特徴量として利用するものである。

- (2)RNNを用いたEncoder-Decoderモデルの一種であり、機械翻訳などのモデルに使われる

- (3)構文木などの木構造に対し、隣接単語から表現ベクトル(フレーズ)を作るという演算を再帰的に行い(重みは共通)、文全体の表現ベクトルを得るNNである。

- (4)RNNの一種であり、単純なRNNにおて問題となる勾配消失問題をCECゲートの概念を導入することで解決したものである。

- A. (2)

Section5:Seq2Seq

確認テスト

- Q. seq2seqとHRED, HREDとVHREDの違いを簡潔に述べよ。

- A. seq2seqとHREDの違い:seq2seqは一問一答しかできないが、HREDは過去のn-1個の発話から次の発話を生成する。そのため、seq2seqは会話の文脈は無視で応答していたが、HREDは文脈に応じた応答ができるようになった。

- A. HREDとVHREDの違い:HREDは確率的な多様性が字面にしかなく、会話の流れのような多様性がない。また、短く情報量に乏しい答えをしがち。一方、VHREDはHREDにVAEの潜在変数の概念を追加してHREDの課題を解決した構造。

確認テスト

- Q. VAEに関する下記の説明文中の空欄に当てはまる言葉を答えよ。

- 自己符号化器の潜在変数に___を導入したもの

- A. 確率分布

Section6:Word2vec

- 該当テストなし

Section7:Attention Mechanism

確認テスト

- Q. RNNとword2vec, seq2seqとAttentionの違いを簡潔に述べよ。

- A.

- RNNとword2vecの違い:RNNは単語のような可変長の文字列をNNに与えることはできないが、word2vecは学習データからボキャブラリを作成することにより、可変長の文字列を扱うことができる。

- seq2seqとAttentionの違い:seq2seqは2単語でも100単語でも固定次元ベクトルの中に入力しなければならないが、Attentionは入力と出力のどの単語が関連しているかの関連度を学習する仕組み

深層学習Day4

確認テストはない。