深層学習後編 実装演習 - s-manabe2/DeepLearningForEngeneerJUDACertificate GitHub Wiki

深層学習Day3

simple RNN

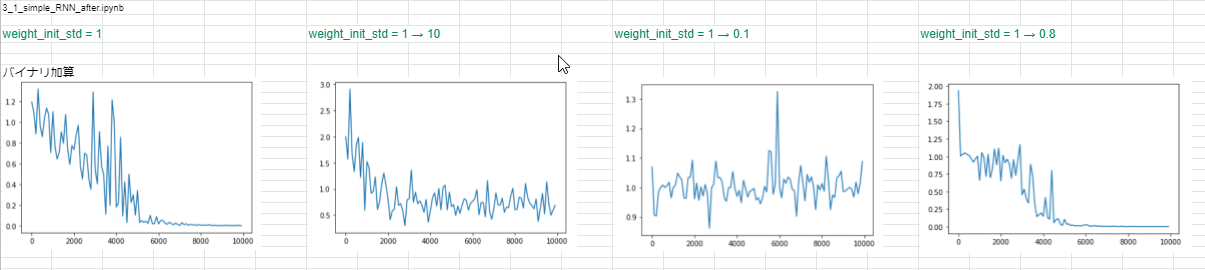

→ 重み初期値の標準偏差は大きくし過ぎても小さくし過ぎても収束しない

→ 重み初期値の標準偏差は大きくし過ぎても小さくし過ぎても収束しない

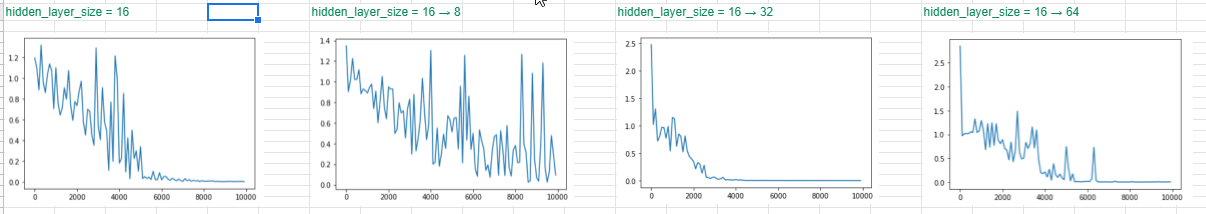

→ 隠れ層数を小さくすると収束しない、大きくすると収束はするが、一部途中で乱れる場合がある。

→ 隠れ層数を小さくすると収束しない、大きくすると収束はするが、一部途中で乱れる場合がある。

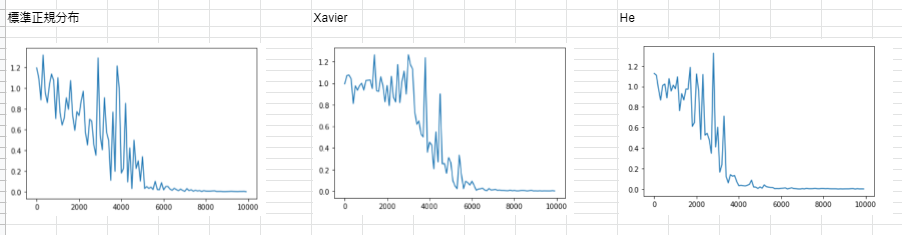

→ どれもiteration_num = 6000位で収束しているが、Heが比較的収束後に安定しているように見える。

<考察> どれもハイパーパラメータを少し変えるだけで学習が収束しないので、経験や勘なども重要なのかと思った。

→ どれもiteration_num = 6000位で収束しているが、Heが比較的収束後に安定しているように見える。

<考察> どれもハイパーパラメータを少し変えるだけで学習が収束しないので、経験や勘なども重要なのかと思った。

predict sin

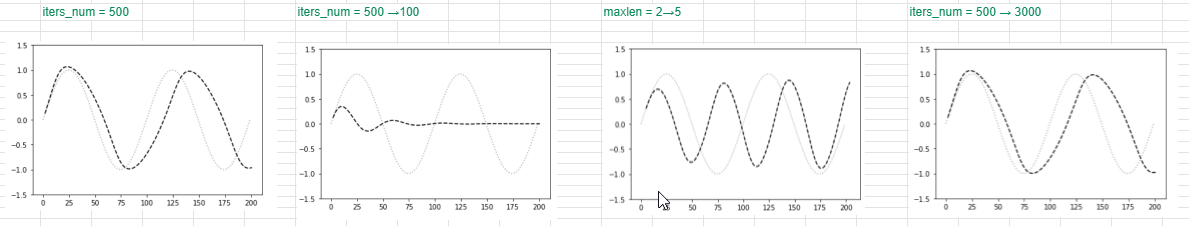

→ 必要以上にiterationを増やしても推論結果はあまり変わらない。max_lenを長くすると位相がずれる。

→ 必要以上にiterationを増やしても推論結果はあまり変わらない。max_lenを長くすると位相がずれる。

深層学習Day4

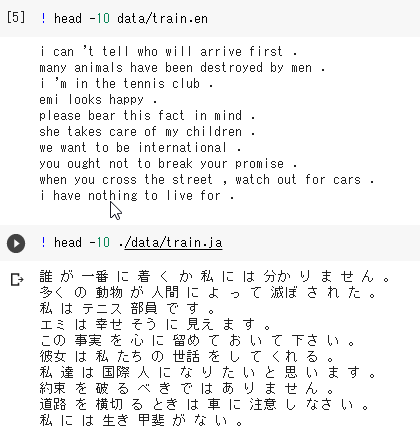

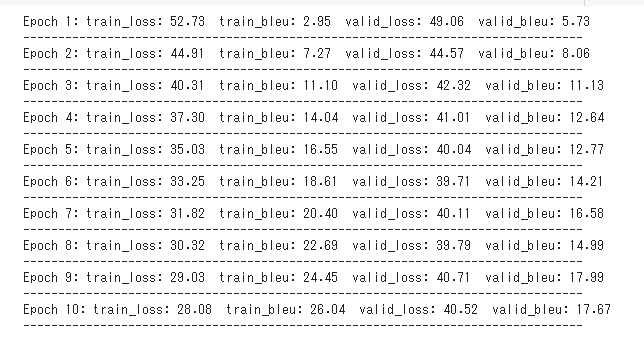

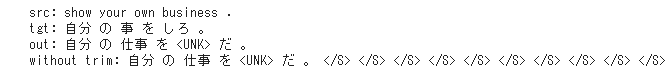

lecture_chap1_exercise_public.ipynb

<考察> BLEU値が18.3とそれほど高くない。

lecture_chap2_exercise_public.ipynb

Transformer

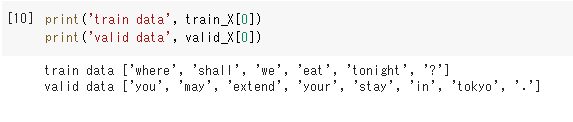

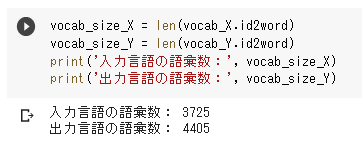

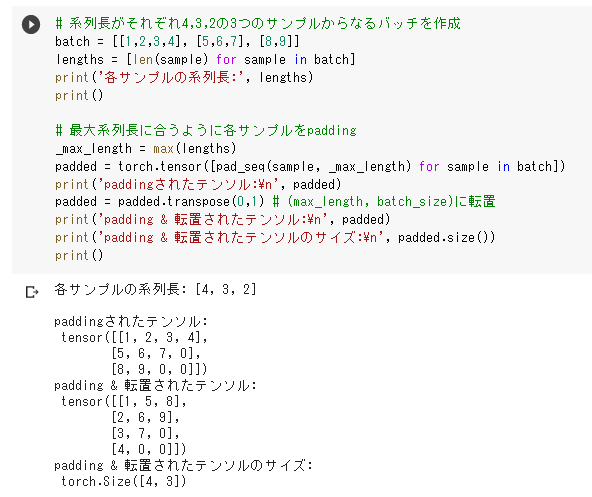

train_X: ['where', 'shall', 'we', 'eat', 'tonight', '?'], ['i', 'made', 'a', 'big', 'mistake', 'in', 'choosing', 'my', 'wife', '.'], ['i', "'ll", 'have', 'to', 'think', 'about', 'it', '.'], ['it', 'is', 'called', 'a', 'lily', '.'], 'could', 'you', 'lend', 'me', 'some', 'money', 'until', 'this', 'weekend', '?' train_Y: ['今夜', 'は', 'どこ', 'で', '食事', 'を', 'し', 'よ', 'う', 'か', '。'], ['僕', 'は', '妻', 'を', '選', 'ぶ', 'の', 'に', '大変', 'な', '間違い', 'を', 'し', 'た', '。'], ['考え', 'と', 'く', 'よ', '。'], ['lily', 'と', '呼', 'ば', 'れ', 'て', 'い', 'ま', 'す', '。'], '今週末', 'まで', 'いくら', 'か', '金', 'を', '貸', 'し', 'て', 'くれ', 'ま', 'せ', 'ん', 'か', '。'

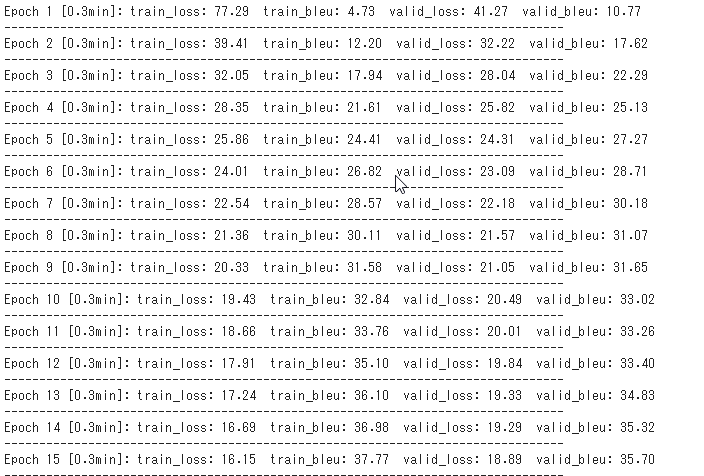

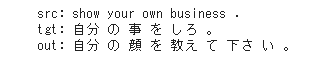

<考察>BLEUの値は40近いと高性能と言われているが、Epoch 15で train_bleug=37.7 valid_bleu=35.7と好成績を出しており、Attentionがすぐれた機構であることが分かる。

<感想>まあ、こんなもんですかねぇという感じ。

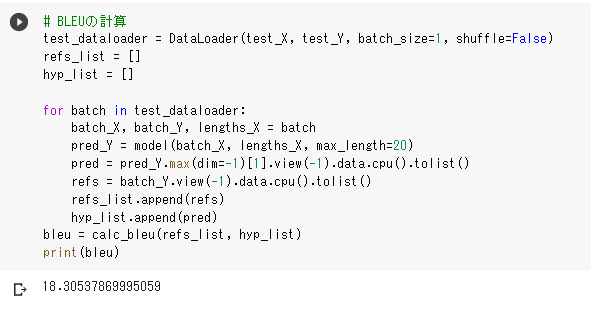

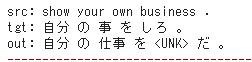

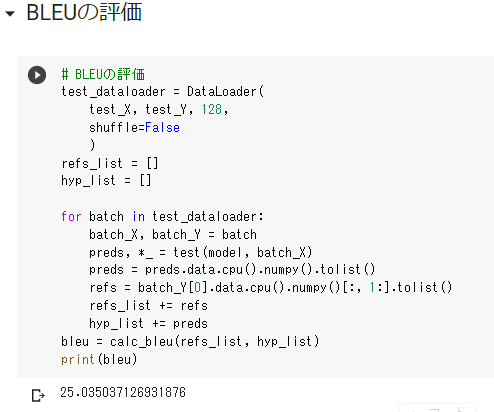

<考察> BLEUの評価値が25.035とそれなりに良い値がでている。

<考察> BLEUの評価値が25.035とそれなりに良い値がでている。